OpenAI ha iniciado el despliegue del modo de voz avanzado, brindando una experiencia conversacional más natural con la IA.

La compañía tecnológica, dirigida por Sam Altman, ha lanzado oficialmente el modo de voz avanzado de ChatGPT para los usuarios suscritos a ChatGPT Plus y Team, ofreciendo mejoras significativas en la interacción con la inteligencia artificial.

Lanzamiento del modo de voz avanzado en ChatGPT

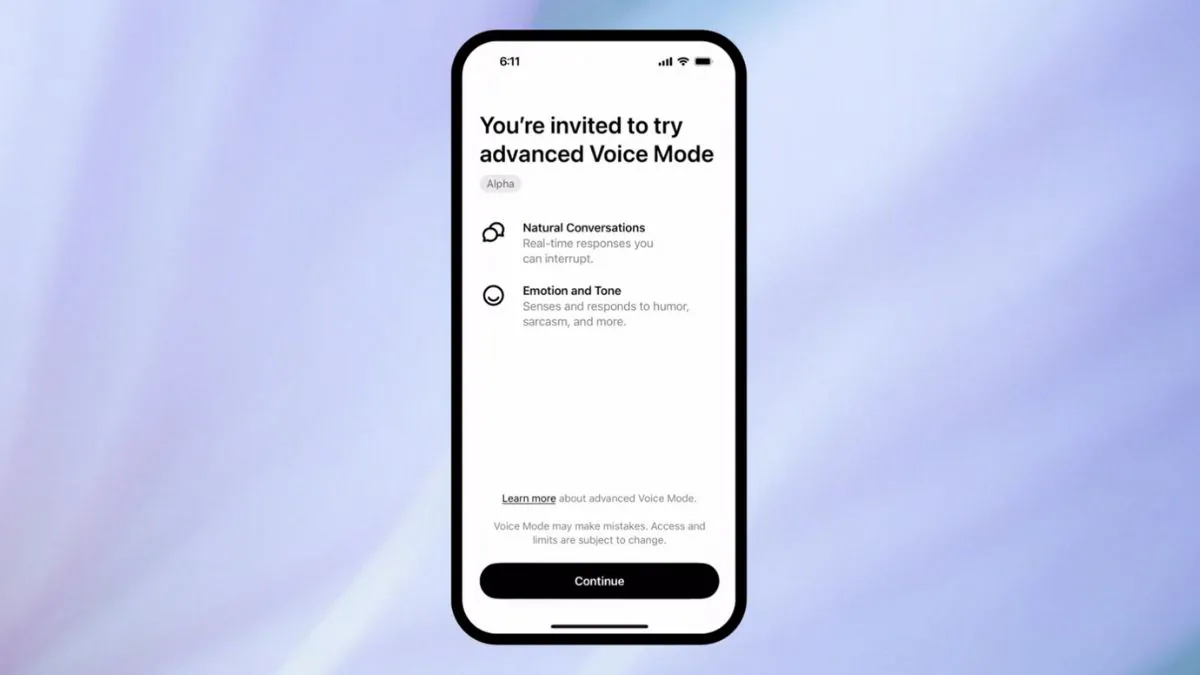

OpenAI ha implementado recientemente el modo de voz avanzado, que permite una conversación más fluida y natural con la IA. Esta nueva funcionalidad incluye la capacidad de seleccionar entre varias voces, lo que otorga una mayor personalización en la interacción. Cinco nuevas voces han sido añadidas con mejoras en los acentos, entre las cuales se encuentran Arbor, Maple, Sol, Spruce y Vale, lo que enriquece la experiencia auditiva.

Este lanzamiento fue anunciado a través de la red social X (anteriormente conocida como Twitter), destacando la importancia de la velocidad, fluidez y memoria de las conversaciones como aspectos clave que mejoran la usabilidad del chatbot. Además, este modo permitirá guardar conversaciones anteriores, lo que facilita consultar respuestas anteriores sin perder el contexto.

Personalización y mejoras en la interacción con la IA

Una de las características más destacadas de este nuevo modo es la posibilidad de incluir instrucciones personalizadas. OpenAI ha señalado que los usuarios pueden configurar cómo debe responder ChatGPT ante sus interacciones, permitiendo ajustar el tono de las respuestas o el nivel de formalidad. Por ejemplo, se puede solicitar que el asistente hable de manera más relajada o que use el nombre del usuario para una interacción más personal.

Estas instrucciones permiten que los usuarios personalicen la conversación a un nivel mucho más profundo, mejorando la experiencia y adaptándola a sus preferencias.

Despliegue gradual y limitaciones geográficas

Aunque el despliegue del modo de voz avanzado ha comenzado para los suscriptores de ChatGPT Plus y Team, no todos los usuarios podrán acceder a esta función de inmediato. OpenAI ha indicado que, por el momento, la nueva funcionalidad no está disponible en la Unión Europea, Reino Unido, Suiza, Islandia, Noruega y Liechtenstein.

La tecnológica explicó que el retraso en el lanzamiento en estas regiones se debe a que están trabajando para asegurar altos estándares de seguridad y fiabilidad, lo que ha generado un despliegue progresivo de la funcionalidad.

Controversia sobre las voces y expectativas futuras

A pesar de las mejoras, el modo de voz avanzado no ha estado exento de polémicas. Uno de los casos más sonados fue la similitud de la voz Sky, que OpenAI usó en una demostración, con la actriz Scarlett Johansson, famosa por dar voz a un asistente de IA en la película Her. Esta similitud generó críticas, lo que llevó a la compañía a retirar la voz de la oferta oficial de este modo avanzado.

El futuro de esta herramienta parece prometedor, y muchos usuarios esperan que el despliegue completo a nivel global llegue pronto. Con su capacidad de combinar entradas de texto, audio e imagen, OpenAI continúa posicionándose como un líder en el campo de la inteligencia artificial conversacional.